petalbot что за бот

скачать русский перевод, моды, скины и стили для phpBB, phpBB3

Атака китайских ботов

Атака китайских ботов

Сообщение hd321kbps » 01.11.2018 23:31

Re: Атака китайских ботов

Сообщение ciiz1 » 01.11.2018 23:59

Re: Атака китайских ботов

Сообщение Siava » 02.11.2018 0:00

Re: Атака китайских ботов

Сообщение ciiz1 » 02.11.2018 0:07

Re: Атака китайских ботов

Сообщение hd321kbps » 02.11.2018 0:21

Re: Атака китайских ботов

Сообщение Siava » 02.11.2018 0:32

Можно куда проще без всяких allow from all. И применить это к корневой директории сразу)

Order Deny,Allow

Deny from x.x.x.x

Deny from y.y.y.y

.

Re: Атака китайских ботов

Сообщение apollion » 02.11.2018 1:01

Я забанил у себя давно все подсети Китая, Южной Кореи, Гонконга, Тайваня, Вьетнама, Таиланда и Камбоджи и еще кучки стран. Через htacsess:

Почему? Потому, что посетители оттуда мне даром не нужны.

Re: Атака китайских ботов

Сообщение ciiz1 » 02.11.2018 1:05

Re: Атака китайских ботов

Сообщение Sheer » 02.11.2018 1:06

Re: Атака китайских ботов

Сообщение apollion » 02.11.2018 1:07

Выше код для Китая.

Отправлено спустя 4 минуты 17 секунд:

Особенно бот Baidu доставучий был.

Re: Атака китайских ботов

Сообщение ciiz1 » 02.11.2018 1:21

Re: Атака китайских ботов

Сообщение apollion » 02.11.2018 1:34

Re: Атака китайских ботов

Сообщение doremyka » 02.11.2018 11:55

О, спасибо!

Я не знала, что можно использовать конструкцию «222.16.0.0/12», блокировала только так: «222.16.0.»

Petalbot что за бот

Периодически мой сайт Новой Усмани посещает PetalBot, который робот поисковой системы Petal Search от компании Huawei.

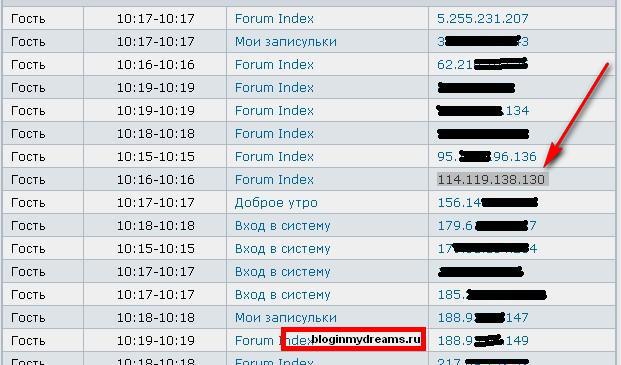

Его айпи на моем сайте показывает 114.119.138.130

Также все запросы PetalBot ведет с сетки с IP 114.119.167.

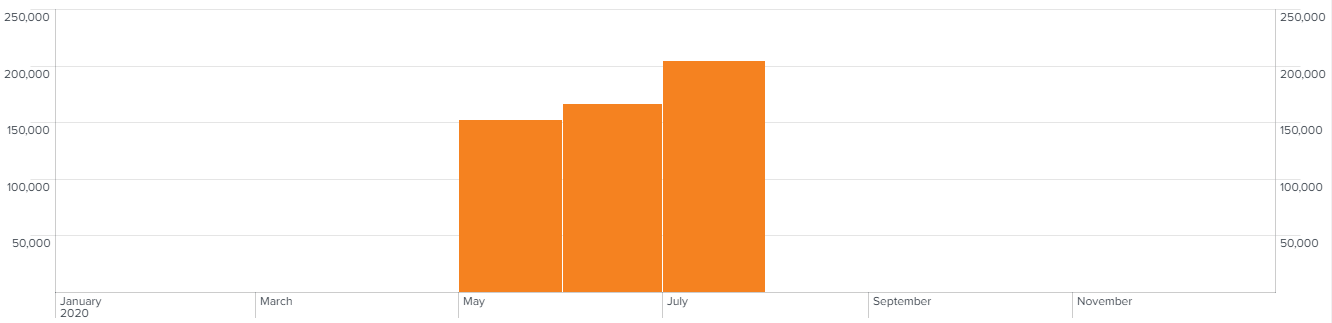

Первая его работа началась 19 июня 2020 года.

Этот бот пока не грузит сайты и является нормальным поисковым ботом в сети интернет!

PetalBot является «вежливым ботом» и при заходе на домен запрашивает файл «/robots.txt» для того, чтобы следовать указаниям вебмастера сайта. Это бот, как и многие другие индексирующие роботы поисковых систем, запрашивает страницы сайта и изображения. Не замечено, чтобы бот запрашивал JS и CSS файлы, следовательно визуальная составляющая его не интересует, только контент.

Свойства бота PetalBot

- бот поисковой системы;

слушает robots.txt;

запрашивает только контент и изображения;

не создает нагрузку на сервер (около 4 запросов в минуту);

большое кол-во IP адресов.

В случае, если бот грузит или нагружает домен, то он легко блокируется в файле robots.txt^

| Код: |

| User-agent: PetalBot Disallow: / |

PetalBot

О боте

PetalBot является также «вежливым ботом» и периодически запрашивает файл «/robots.txt» для того, чтобы следовать указаниям вебмастера сайта. Это бот, как и многие другие индексирующие роботы поисковых систем, запрашивает страницы сайта и изображения. Не замечено, чтобы бот запрашивал JS и CSS файлы, следовательно визуальная составляющая его не интересует, только контент.

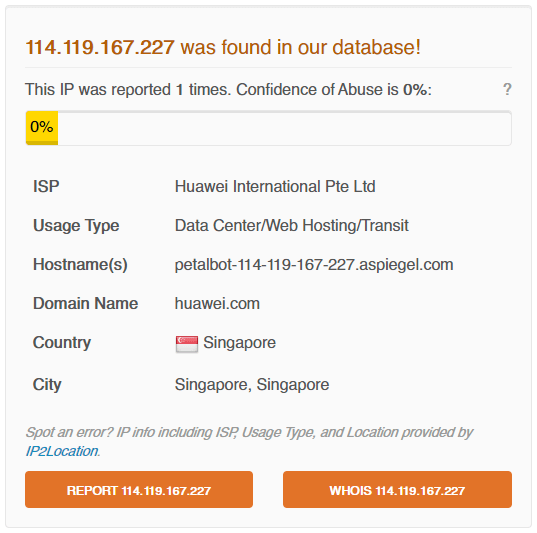

По IP адресу можно увидеть прозрачную информацию о его происхождении и инициаторе:

Например по примеру выше можно понять, что запросы с IP 114.119.167.227 выполнялись подлинным ботом: сервер находится в Сингапуре, провайдер Huawei International Pte Ltd и хост aspiegel.com. Для валидации советую использовать валидатор ботов.

Поведение бота

Этот бот был замечен в логах сервера, в моем случае, с 20 мая 2020:

В 99,9% случаев бот делал запросы с User-Agent:

Mozilla/5.0 (Linux; Android 7.0;) AppleWebKit/537.36 (KHTML, like Gecko) Mobile Safari/537.36 (compatible; PetalBot;+https://aspiegel.com/petalbot)

Все запросы производятся по методу GET и, как оказалось, все они были от PetalBot (mobile), а «PC» так и не пришёл. Исходя из данных в логах заметно равномерное распределение запросов между IP адресами. В среднем кол-во запросов каждого IP адреса бота составляет 2,4% от общего кол-ва запросов.

Также стоит отметить что запросы PetalBot производятся с большого кол-ва IP адресов. В моем случае с 20 мая по 26 июля бот делал запросы к серверу с 451 различного IP адреса (скачать список). За июнь бот сделал 166К запросов к серверу (около 4 запросов в минуту), но уже в июле число запросов превышает 204К (на 26 июля, аппетит растет). В моем случае на проекте более 20М страниц, следовательно еще и поэтому такое кол-во запросов. Исходя из такой интенсивности бота нагрузку на сервер он не должен создать.

Как заблокировать ботов по User-agent

Для чего блокировать некоторых поисковых ботов

Активность сканирующих ботов и роботов-пауков известных поисковых систем обычно не влияет на загрузку сайта и не уменьшает скорость его работы. Но большая часть сканирующих ботов бесполезна и даже может повредить производительности сайта.

Например, боты DotBot или Semrush. Были случаи, когда эти боты посылали так много запросов к сайту, что это было похоже на небольшую DDoS атаку. Большое количество запросов перегружает сайт и веб сервер, таким образом сайт может стать недоступным для других посетителей.

Мы настоятельно рекомендуем блокировать чрезмерно активных ботов, если на вашем сайте более 100 страниц, особенно если вы уже исчерпали ограничения предоставленные вам вашим хостингом.

Два способа заблокировать вредоносных ботов

1. С помощью включения опций Anti-Flood и Anti-Crawler плагина Анти-Спам от CleanTalk.

Этот способ предпочтительнее, т.к. плагин определяет активность ботов по их поведению. Любой бот с высокой активностью будет автоматически перенаправлен на 403 на некоторое время, независимо от user-agent и других признаков. Поисковые боты Google, Bing, MSN, Yandex добавлены в исключения и не будут блокироваться.

1. Как заблокировать бота Baidu

Для nginx.conf:

Добавьте этот код в раздел HTPP<> файла nginx.conf:

2. Как заблокировать бота AhrefsBot

для nginx.conf:

Добавьте этот код в раздел HTPP<> файла nginx.conf:

3. Как заблокировать бота MJ12bot

Для nginx.conf:

Добавьте этот код в раздел HTPP<> файла nginx.conf:

4. Как заблокировать бота Detectify

Для nginx.conf:

Добавьте этот код в раздел HTPP<> файла nginx.conf:

5. Как заблокировать бота DuckDuckGo

Как блокировать ботов и краулеров на сайте

Здравствуйте, дамы и господа, в этой статье хочу рассказать о том, как я блокирую вредных ботов, например, ботов ahfers, Semrush, PetalBot, Majestic, Megaindex и многих других. В целом, боты, которые активно копаются по сайту, создают очень много проблем. И на определённом этапе начинают съедать огромное количество ресурсов сервера, на котором расположен ваш сайт.

Ботов необходимо блокировать

Мало того что боты создают дополнительную колоссальную нагрузку на сервер, что выльется в оплату дополнительных ресурсов для оного. Ну или в более дорогой тариф для хостинга.

В общем, благодаря информации, которую собирают данные сервисы, ваш сайт у конкурентов как на ладони. Так что ботов нужно блокировать, особенно если у вас коммерческий проект.

Но просто знайте, что чем старше ваш сайт и заметнее в сети, тем больше ботов на него будет приходить. Сначала их численность будет незначительной, а создаваемая нагрузка не будет представлять собой проблему.

Со временем ботов станет очень много, ресурсов хостинга или сервера не будет хватать. Банально, на моём сайте возникла такая ситуация. Мне даже пришлось перевести сайт на другой хостинг, чтобы хватало ресурсов, но и там ресурсов хватало почти вплотную.

Нагрузка на сервер упала очень даже заметно. Конечно, 20-30% — разница не самая большая, но чем крупнее сайт, тем больше ботов на нём будет, соответственно, эти 20-30% разницы превратятся в переплаты за хостинг или VPS.

Конечно, результат может показаться не самым впечатляющим, но оно того стоило. Теперь мне не нужно докупать дополнительные CP или переходить на тариф подороже, соответственно, простой блок ботов позволяет сэкономить деньги.

Вам рекомендую сделать то же самое.

Как блокировать плохих ботов

Разделим ботов на две части:

Полезные. Боты поисковых систем и их сервисов. Например, YandexBot, GoogleImage. Их блокировать нельзя, это плохо скажется на ваших позициях в поисковых системах.

Плохие боты. Разные сервисы вроде SemRush, Ahfers, Megaindex и т. п. В общем, именно их будем отрезать.

После блокировки всевозможных плохих ботов у вас значительно упадёт нагрузка на сервер. Если от вашего хостера приходят уведомления, что превышен лимит процесс о рного времени ( CP ), то самое время отрезать часть плохих ботов. Какие ро боты и краулеры конкретно увеличивают нагрузку, можете увидеть в логах.

Найти логи мож но на сервере, как правило, логи посещений пишутся в отдельные журналы. Например, в Fozzy их можно увидеть в разделе «Статистика» в панели DirectAdmin, на Бегет придётся отдельно включить «Журналы доступа» в панели управления хостингом. В общем, если сами не знаете, как это сделать, задайте вопрос вашему хостеру, они с этим помогут.

После вы увидите примерно такую картину, где в логах будут записаны куча User-Agent, разнообразных IP, а также время посещения.

Бездумно блокировать всё подряд не рекомендую. Нужно вычленить именно бота, если блокировать всех «юзер-агентов», то заблокируете и реальных посетителей.

Многие боты себя идентифицируют. Таких отсечь легче всего.

Некоторые боты себя не идентифицируют или даже маскируются под краулеры. Их отсекать можно по IP- адресам, но это практически бесполезно, так как у вредоносных роботов IP- адреса постоянно меняются.

Также можно настроить фильтрацию посредством обратных DNS- запросов, но это задача непростая, так что в этой статье ограничимся разбором блокировки идентифицируемых ботов, а также наиболее «наглых» IP- адресов.

Этот вариант самый лучший, так как боты и краулеры частенько игнорируют директивы из robots.txt. Есть вариант блокировать с помощью команды SetEnvIfNoCase User-Agent или через ReveriteCond. Первый способ получше. Ну, лично для меня.

В данном списке я собрал именно тех ботов, которых выловил на своём сайте. И блокировка сработала. В логах вы увидите, что ботам выдаётся ответ сервера 403, соответственно, нагрузка на ваш сайт снизится.

Учтите, на многих сайтах есть аналогичные списки для блокировки ботов и краулеров. Рекомендую их бездумно не копировать, подобные директивы часто сделаны людьми из-за рубежа, соответственно, там бездумно блокируют краулеры Яндекс и Mail.ru, что плохо скажется на позициях сайта в Яндекс.

Банальный пример кода:

И многие контент-мейкеры из СНГ бездумно копируют такие коды себе на сайты. Так что смотрите внимательно и анализируйте.

В своих вариантах я опубликовал только тех ботов, которые атакуют мой сайт. В ваших логах могут быть иные роботы и краулеры.

У себя использую такой код, он оказался вполне работоспособным:

Потом в логах можете увидеть, что заблокированным ботам выдаётся ответ сервера 403:

Соответственно, бот не сможет парсить контент, а также скачивать данные сайта, например, rss- ленты или другие фиды.

Есть ещё один вариант кода, работать может не на всех серверах:

Работать данные варианты будут только с теми ботами, которые себя идентифицируют. Если же боты маскируются под другие краулеры или притворятся реальными посетителями, то такие методы не сработают.

Можно их банить по IP, но об этом чуть дальше.

Блокировка ботов через robots.txt

Некоторые боты можно банить через файл robots.txt. Но работает это только при одном условии: если робот или краулер не игнорирует директивы, прописанные в этом файле. По своим логам видел, что многие боты даже не запрашивают этот файл никогда, соответственно, директив в нём даже не увидят.

В общем, мы запретили обход сайта определённому User-Agent. Но, как уже сказал, бот может просто проигнорировать данную директиву.

Также можем через файл robots.txt не только заблокировать бот, а, например, указать скорость обхода, чтобы он продолжил находиться на сайте, но сильно его не грузил.

Crawl-delay позволяет установить задержку между запросами, но данная директива считается устаревшей, большинство ботов её игнорирует, соответственно, её использование не выглядит целесообразным.

В общем, на robots.txt нельзя надеяться при блокировке ботов, так как большей частью роботов этот файл попросту игнорируется.

Блокировка ботов и краулеров по IP

Бывает, в логах попадаются очень наглые боты, которые не идентифицируют себя, но генерируют большую нагрузку на сервер. Защитить от них может либо какая-нибудь AntiDDoS- система, капча и тому подобные фишки, либо блокировка по IP.

Блокировка по IP целесообразна только тогда, когда определённый бот посылает много запросов с 1-го IP- адреса.

Но, как правило, в этом мало смысла, у ботов, как правило, много IP в запасе, соответственно, при дискредитации 1-го адреса бот быстро появится с другого.

Но иногда данный вариант помогает. Но всегда проверяйте IP перед блокировкой, самым «наглым» IP в логах может оказаться ваш собственный. Также можно чисто случайно забанить IP краулеров Яндекс или Google.

Код для блокировки выглядит так:

Каждый новый IP в список добавляйте через пробел.

Блокировка ботов пойдёт вашему сайту на пользу

Чуть-чуть разгрузит сервер, а также информации о вашем сайте у конкурентов будет поменьше, так что не стесняйтесь и блокируйте. Инструкцию приложил. Конечно, если ваш сайт усиленно долбят боты с разных IP и никак себя не идентифицируют, придётся подумать о более серьёзных методах защиты, но частенько для того, чтобы снизить нагрузку на сервер будет достаточно тех методов, что предложил выше.

На этом с вами прощаюсь, желаю успехов, а также поменьше вредных ботов на сайте!

Насколько публикация полезна?

Нажмите на звезду, чтобы оценить!

Средняя оценка 4.2 / 5. Количество оценок: 5