нейросеть аниме персонажи в реальной жизни

Нейросеть делает из людей, аниме персонажей

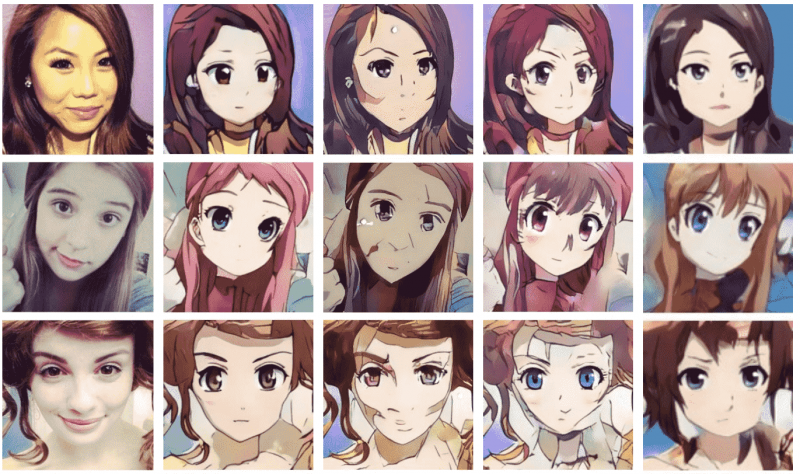

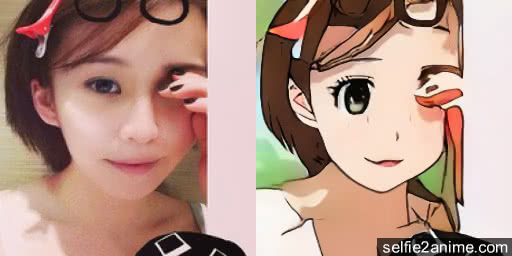

Австралийские разработчики создали сайт Selfie2Anime, который анализирует лицо человека на фото и перерисовывает его в стиле аниме. От пользователя требуется только загрузить снимок на сайт и указать электронную почту — туда придет готовое изображение.

Добавлю от себя, что в основном получается дичь, но бывает и годнота.

Найдены возможные дубликаты

Шея на данной картинке, напоминает шею человека, умершего благодаря асфиксии вследствии самоудушения веревкой.

Поставь это на аватарку на пикабу

сеть восприняла мою бороду как модный шарфик

Так за это мы и любим нейросети.

делает из людей, аниме персонажей

Лишняя запятая. Получается, что кто-то что-то делает из людей, а аниме персонажей. мы все ждем, чего нам ждать от аниме персонажей.

А запятая где, брат?

Возможно ты сам аниме персонаж, по этому менять нечего.

Хочешь перенести в машинное обучение (мб плюсов больше прилетит)? Тогда зови модератора

Не похер ли на плюсы

Подписчики у меня не прибавятся, подписываются на тех кто планирует серию постов выкладывать, либо на очень топовых пользователей которые 8/10 годноту постят.

Я же просто поделился интересным ресурсом который мне показался смешным.

Как хочешь конечно, но кажется, что призыв модератора это даже короче, чем писать комментарии

всего 1 парень. и 1 обезьяна:)

Требует емеил, ну нахер

А на пикабу еще и телефон.

Однако вы тут.

юзай почту на 5 минут которая (в среднем 3 минуты надо ждать)

Требует почту. Наебка

Очередной сервис по сбору тупых лиц.

Умные себя не зашлют.

Умные знают что вся их информация давно у третьих лиц. Да и кому ты нужен, если честно.

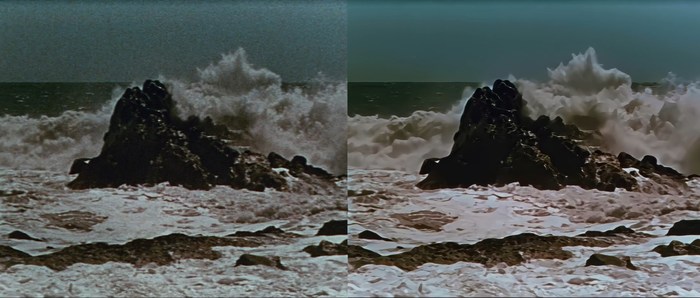

Корабль-призрак 4K

Немного улучшил старое аниме.

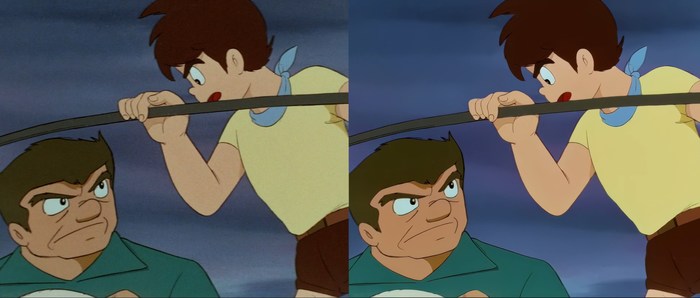

Кот в сапогах. Вокруг света за 80 дней. 4K

Немного освежил старое доброе аниме.

Sailor Moon ( Финальная битва в 4К)

Продолжаю апскейлить в 4K

Заливаю в облако т.к. сюда не влезает

Продолжаю предыдущие посты

Хентайчик Words Worth готово 3 серии из 5. уже скоро.

Апскейл до FullHD первых серий One Piece, Shaman King, Spider-man, Batman

В новой версии программы добавили три новые сетки, со вшитым повышением fps видео в два раза.

Артефакты показались только в Человеке-пауке, и то лишь в паре сцен.

Нейросеть Selfie2Anime превратит вас на фото в героя аниме

Нейросетям сегодня находят самое различное применение, причем не только серьезное. Мы уже писали о сервисе DeepNude, который раздевает девушек. Теперь у пользователей сети появилось новое развлечение — программа, превращающая людей на фото в героев аниме.

Если вы хотите узнать, какой бы была ваша внешность в аниме, то теперь у вас есть такая возможность! Сервис Selfie2Anime, использующий нейросеть, быстро превратит вас на снимке в персонаж в стиле японской анимации. В основе программы лежит алгоритм, созданный компанией NCSoft, создателем популярной компьютерной игры Lineage II.

Нейросеть от NCSoft умеет не только перевоплощать людей в аниме-героев. Ранее ее возможности использовали для того, чтобы превращать фотографии в картины и обычных лошадей на снимках в зебр.

Сразу нужно предупредить, что человек не вмешивается в работу сервиса Selfie2Anime — все операции выполняет нейронная сеть, использующая алгоритмы машинного обучения. Наверное поэтому результаты обработки снимков иногда бывают очень странными. Но, если не придираться к мелочам, можно считать, что со своей задачей электронный разум справляется неплохо.

Чтобы воспользоваться услугами нейросети и получить свой портрет в стиле аниме, зайдите на сайт Selfie2Anime и отправьте свою фотографию для обработки системой. Результат сервис пришлет на электронную почту всего через несколько минут.

А вы знали, что у нас есть Instagram и Telegram?

Подписывайтесь, если вы ценитель красивых фото и интересных историй!

Миядзаки, подвинься. Студенты создали нейросеть, превращающую всё в аниме, но людей она, увы, не любит

Студенты из Китая создали нейросеть, которая превращает любые фото в кадры из аниме. Теперь не надо быть Хаяо Миядзаки, чтобы создать шедевр, вот только, если захотите снять мультфильм с участием людей — подумайте дважды. Программа их не щадит.

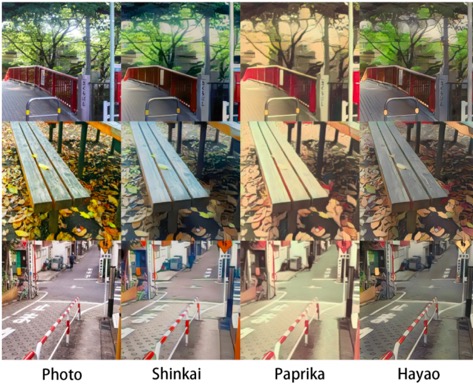

Цзе Чен, Ган Лю и Синь Чен, студенты Университета Уханя и Технологического университета Хубэй, разработали нейросеть AnimeGAN, позволяющую превращать всё вокруг в аниме, пишет SoraNews 24.

Благодаря программе обычное фото с автобусом за секунды может стать кадром мультфильма. Если не знать наверняка, можно запросто подумать, что изображение нарисовано профессиональным иллюстратором.

В начале августа создатели улучшили своё творение, и теперь в нём можно не ограничиваться лишь одним фильтром, а выбирать несколько в зависимости от предпочтений пользователя.

И самое интересное, три фильтра названы либо в честь известных режиссёров аниме, либо в честь их работ. Hayao отсылает к Хаяо Миядзаки и его «Ветер крепчает», Paprika — к мультфильму Сатоси Кона «Паприка», а Shinkai — к режиссёру Макото Синкаю, создателю картины «Твоё имя».

Нетрудно догадаться, что в каждом из фильтров применяются стили того или иного создателя.

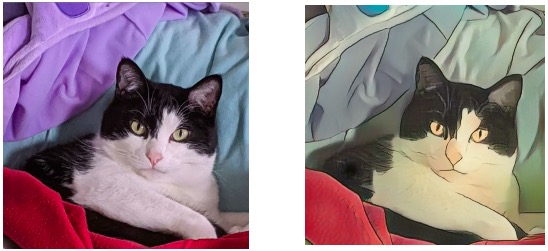

Оценить возможности нейросети можно уже сейчас, не загружая какие-либо дополнительные программы, а перейдя по ссылке. Фильтры пока недоступны, поэтому загруженное изображение будет просто преобразовано в картину в стиле аниме, без привязки к какой-либо «фишке».

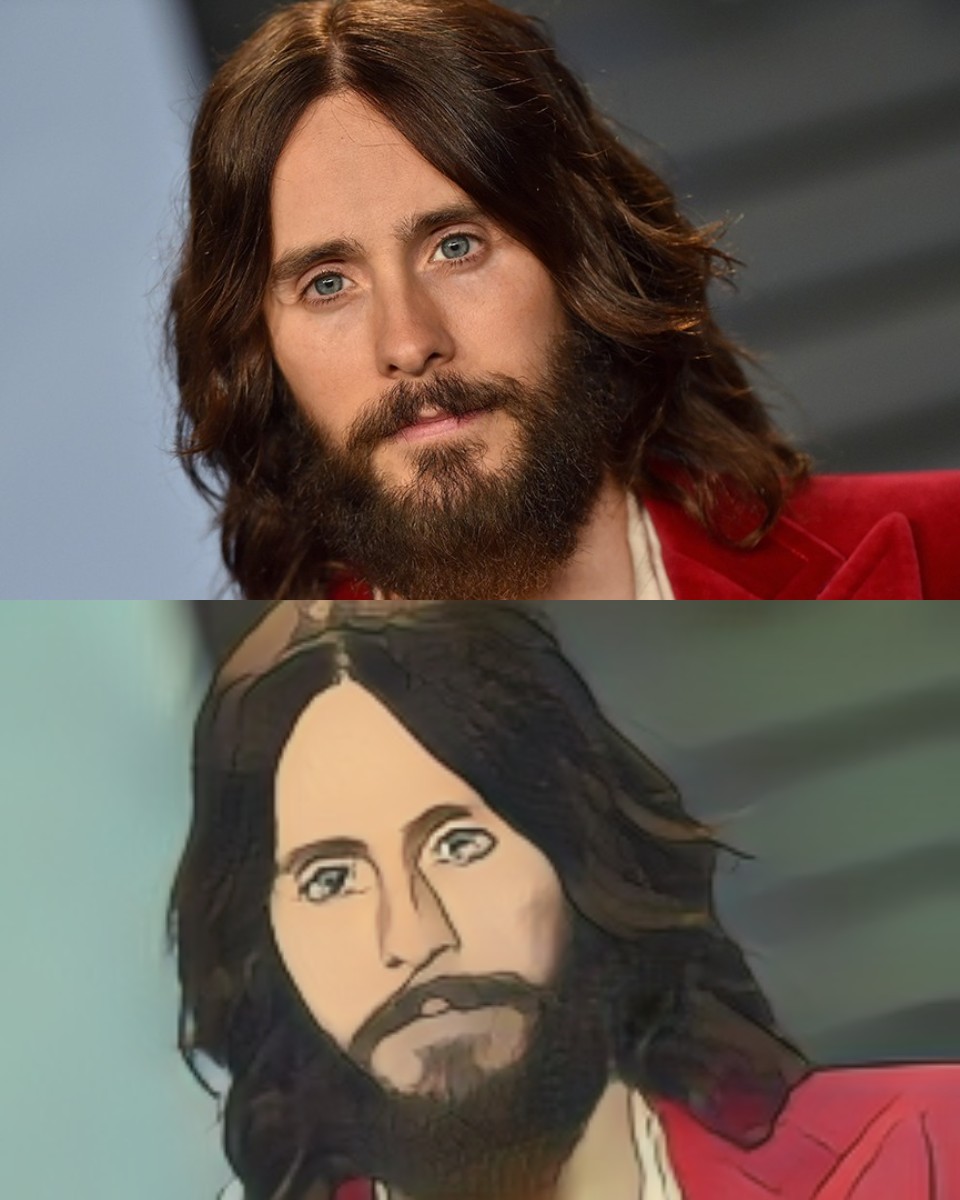

У нейросети есть лишь один недостаток — людей пропускать через неё не стоит, ведь они получаются не героями аниме, чьи эмоции выглядят достаточно нелепо в реальной жизни, а просто грустными портретами, которые нарисовал школьник во время урока математики.

Убедиться в этом можно, посмотрев на анимешных Джареда Лето, которого завалили мемами после новости о его роли в «Троне-3», и Ким Кардашьян, загадочно поздравившую свою сестру с днём рождения.

Так что, если хочется почувствовать себя преемником Миядзаки, — AnimeGAN к вашим услугам, но начинать придётся с пейзажей и, максимум, животных, но не людей, если не хотите ненароком обидеть своих знакомых, решивших сыграть в вашем шедевре.

Тем, кому всё же хочется посмотреть на себя в нарисованном виде, можно обратиться к программе Artbreeder, которая сама создаёт портреты людей. Такими темпами настоящие художники могут потерять работу.

Также можно запросто узнать, каким бы вы были, если бы стали оборотнем, с помощью Humanimals. Спойлер: хорроры нас обманывают.

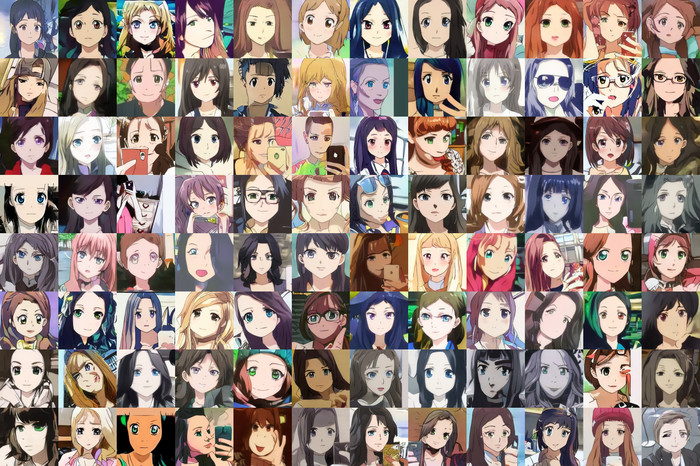

Генерация аниме с помощью нейросети StyleGAN

StyleGAN — та самая нейросеть, которая генерирует лица несуществующих людей на сайте thispersondoesnotexist.com. Исследователь Gwern Branwen вывел её на новый уровень и научил создавать несуществующие лица персонажей аниме, запустив свой сайт thiswaifudoesnotexist.net. На нём каждые 15 секунд появляется новый персонаж и его история, также генерируемая искусственным интеллектом. Сегодня мы расскажем, как самому обучить нейросеть для создания аниме-лиц с помощью StyleGAN.

В попытках заставить компьютер рисовать аниме есть что-то забавное — это уж точно интереснее, чем работать со снимками знаменитостей или с датасетом ImageNet! Кроме того, рисунки и аниме отличаются от фотографий, которые сейчас очень часто используются в задачах машинного обучения. Если нейросети научатся генерировать случайные нарисованные изображения, то совсем скоро станет возможна генерация картин и фотографий по их текстовому описанию.

Gwern пробовал решить задачу с помощью ряда существующих генеративных сетей: StackGAN / StackGAN ++ & Pixel * NN *, WGAN-GP, Glow, GAN-QP, MSG-GAN, SAGAN, VGAN, PokeGAN, BigGAN 3, ProGAN и StyleGAN. Многие из них начинали либо расходиться после одного или двух дней обучения, либо создавать ограниченный диапазон лиц (или одно лицо), либо просто сходиться к изображениям плохого качества.

Первый успех продемонстрировали сети BigGAN и ProGAN: они показали, что обычные CNN могут научиться генерировать и масштабировать чёткие аниме-изображения. Сеть ProGAN была достаточно мощной, но требовала около 6 недель обучения на GPU. Поэтому ей на смену пришла StyleGAN — более быстрая архитектура, с которой можно обучать объёмные модели на больших наборах данных.

StyleGAN стала настоящим прорывом, поскольку предоставляла возможности уровня ProGAN, но работала быстрее. Эта сеть с радикально иной архитектурой минимизирует потребность в медленном прогрессивном росте (возможно, полностью его исключая) и эффективно обучается на изображениях с разным разрешением. Кроме того, она позволяет контролировать генерируемые кадры с помощью механизма передачи стиля.

Примеры

Для начала продемонстрируем возможность StyleGAN генерировать аниме-лица:

озможность StyleGAN генерировать аниме-лица:

Стоит отметить, что лица получаются очень разнообразными: меняется не только цвет волос или глаз, ориентация головы и другие мелкие детали, но и общий стиль. Изображения могут быть похожи на кадр из мультфильма, компьютерную графику, аниме 90-х и 00-х годов и даже на рисунки акварелью или маслом.

Видео, демонстрирующие разнообразие аниме-лиц:

О StyleGAN

StyleGAN представлена в 2018 году. Она использует стандартную архитектуру GAN, применяемую в ProGAN, но черпает вдохновение из механизма передачи стиля. StyleGAN модифицирует свою генераторную сеть (генератор), которая создаёт изображение путём его многократного увеличения: 8px → 16px → 32px → 64px → 128px и т. д. При этом на каждом уровне используется комбинация случайных входных данных или «стилевого шума» (“style noise”) с AdaIN. Это указывает генератору, как стилизовать изображения с определённым разрешением: изменить волосы, текстуру кожи и так далее. Систематически создавая такую случайность на каждом этапе процесса формирования изображения, StyleGAN может эффективно выбирать более удачные варианты.

StyleGAN вносит также ряд дополнительных улучшений: например, в ней используется новый датасет лиц “FFHQ” с изображениями размером 1024 пикселя (выше, чем у ProGAN). Кроме того, сеть демонстрирует меньше потерь и очень интенсивно использует полностью связанные слои для обработки случайного ввода (не менее 8 слоёв из 512 нейронов, в то время как у большинства GAN 1 или 2 слоя). Ещё более поразительным является то, что в StyleGAN не используются методы, которые считались критически важными для обучения других GAN: например, релятивистские потери, распределение шума, расширенная регуляризация и т. д.

За исключением этих особенностей, архитектура довольно обычная. Поэтому если вы имели дело с какой-либо GAN — можете смело работать со StyleGAN. Процесс обучения тот же, гиперпараметры стандартные, а код во многом совпадает с ProGAN.

Приложения

Благодаря своей скорости и стабильности StyleGAN успела приспособиться к широкому кругу задач. Вот некоторые из её применений:

— гостиничные номера (с текстовыми описаниями, сгенерированными RNN): Этого номера не существует

кухня / столовая / гостиная / спальня (с использованием трансферного обучения)

Что нужно для обучения

Данные

Необходимый размер набора данных зависит от сложности задачи и от того, применяется ли трансферное обучение. По умолчанию StyleGAN использует довольно большую модель генератора, способную потенциально обрабатывать миллионы изображений, поэтому данных много не бывает.

Для обучения аниме-персонажам приемлемого качества с нуля требуется минимум 5000 изображений. Для таких сложных задач, как «несуществующая кошка» использовалось

180 тыс. снимков. Судя по многочисленным ошибкам, проблема либо в недостаточности этих данных, либо в сложности генерации кошек.

Вычисление

Для того чтобы обеспечить достаточный размер мини-пакетов, потребуются графические процессоры с > 11 ГБ видеопамяти, например, Nvidia 1080ti или Nvidia Tesla V100.

Репозиторий StyleGAN предоставляет приблизительные сроки обучения для систем с 1-8 GPU. Сконвертировав их в общее количество часов работы GPU, мы получим следующее:

Предполагаемое время обучения StyleGAN при различных разрешениях изображений и используемых GPU (источник: репозиторий StyleGAN)

| Число используемых GPU | 1024 2 | 512 2 | 256 2 | [Апрель 2019 г., тарифы REG.RU ] |

| 1 | 41 день 4 часа [988 GPU-часов] | 24 дня 21 час [597 GPU-часов] | 14 дней 22 часа [358 GPU-часов] | [₽89к, ₽54к, ₽32к] |

| 2 | 21 день 22 часа [1052] | 13 дней 7 часов [638] | 9 дней 5 часов [442] | [105к, 64к, 44к] |

| 4 | 11 дней 8 часов [1088] | 7 дней 0 часов [672] | 4 дня 21 час [468] | [131к, 81к, 56к] |

| 8 | 6 дней 14 часов [1264] | 4 дня 10 часов [848] | 3 дня 8 часов [640] | [177к,, 119к, 90к] |

Подготовка данных

Обратите внимание: набор данных StyleGAN должен состоять из одинаково отформатированных изображений: они могут быть только 512х512 пикселей или только 1024х1024 и т. д. и относиться к одному и тому же цветовому пространству (вы не можете использовать одновременно RGB и градации серого). Тип файлов должен быть таким же, как у модели, которую вы собираетесь (пере)обучать (нельзя переобучить PNG-модель на наборе данных JPG). Кроме того, в файлах не должно быть никаких ошибок, например, неправильной контрольной суммы CRC — их часто игнорируют библиотеки и средства просмотра изображений.

Подготовка лиц

Процесс подготовки лиц:

Цель состоит в том, чтобы превратить это:

Ниже представлены shell-скрипты для подготовки датасета. Альтернативой может быть использование утилиты danbooru-utility, которая позволяет исследовать набор данных, фильтровать по тегам, оценивать, обнаруживать лица и изменять размеры изображений.

Обрезка

Загрузить датасет Danbooru2018 можно через BitTorrent или rsync. Вы получите тарболл метаданных JSON, распакованный в папку metadata/2* и структуру данных

Идентификаторы можно извлечь из имён файлов напрямую, или же из метаданных:

Этот скрипт обрабатывает только одно входное изображение. Выполнить обрезку фотографий параллельно можно следующим образом:

Здесь мы устанавливаем параметр CUDA_VISIBLE_DEVICES=»» — это отключает использование GPU, поскольку для этой задачи он не даёт очевидного ускорения.

Очистка и масштабирование

Удаление ненужных файлов:

Следующий важный шаг — масштабирование изображений с помощью нейросети waifu2x, которая хорошо справляется с двукратным увеличением аниме-кадров. Но она работает довольно медленно (1-10 секунд на изображение), запускается только на GPU и написана в неподдерживаемом в настоящее время DL-фреймворке Torch. Можно попробовать использовать другую GAN сеть для увеличения разрешения (например, SRGAN, о которой мы писали ранее).

Если вы хотите сэкономить время, можете масштабировать лица с помощью обычного ImageMagick, но их качество будет невысоким.

Проверка и дополнение данных

Масштабирование (ещё раз) и преобразование

После дополнения данных неплохо было бы сэкономить место на диске, преобразовав изображения в JPG и снизив качество примерно на 33%. Так можно освободить достаточно много дискового пространства без видимых потерь:

Не забудьте, что модели StyleGAN совместимы только с изображениями того типа, на котором были обучены.

Теперь масштабируем все изображения к размеру 512х512 пикселей с помощью ImageMagick без сохранения пропорций:

Любое ошибочное изображение может привести к сбою процесса импорта, поэтому мы удалим всё, что отличается от JPG 512×512 sRGB:

Но если вы проверили изображения ранее, проблем быть не должно. Преобразование выполняется следующим образом:

Поздравляем, самое сложное позади!

Обучение модели

Установка

Предполагается, что у вас присутствует и работает CUDA. Автор проекта использовал ОС Ubuntu Bionic 18.04.2 LTS и версию драйвера Nvidia # 410.104, CUDA 10.1.

Также вам понадобится Python версии 3.6 и выше, TensorFlow и зависимости для StyleGAN:

Конфигурация

StyleGAN не поддерживает опции командной строки, вместо этого необходимо отредактировать train.py и train/training_loop.py :

1. train/training_loop.py

Исходная конфигурация указана в функции training_loop в строке 112.

Ключевыми аргументами являются:

G_smoothing_kimg и D_repeats : влияют на динамику обучения

network_snapshot_ticks : указывает, как часто сохранять скриншоты

resume_run_id : установлен на «latest»

resume_kimg : указывает на финальное значение разрешения генерируемых изображений

2. train.py (ранее config.py )

Здесь мы устанавливаем число графических процессоров, разрешение изображений, набор данных, скорость обучения, зеркальное отражение или дополнение данных и размер мини-пакетов. Этот файл включает себя настройки, предназначенные для ProGAN — следите за тем, чтобы случайно не запустить ProGAN вместо StyleGAN и не запутаться.

Значения скорости обучения и размера пакетов можно оставить по умолчанию. Но разрешение изображений, набор данных и зеркальное отражение укажите обязательно:

Так выглядит сообщение об ошибке:

У автора для 2x1080ti установлено:

Запуск

StyleGAN можно запустить в GNU Screen, который поддерживает несколько оболочек: 1 терминал для запуска StyleGAN, 1 для TensorBoard и 1 для Emacs.

В Emacs можно открыть файлы train.py и train/training_loop.py для справки и быстрого редактирования.

TensorBoard — это визуализатор записанных во время обучения значений, которые можно посмотреть в браузере, например:

TensorBoard может работать в фоновом режиме, но не забывайте обновлять его с каждым новым запуском.

Обучение StyleGAN — это скорее искусство, чем наука. Более подробные советы по настройке и регулировке процесса можно найти на сайте автора проекта.

Так выглядит успешное обучение:

Генерация аниме

А теперь самое интересное — создание образцов!

Для начала поясним значение гиперпараметра 𝜓. Это так называемый «трюк усечения» (“truncation trick”), который используется во время генерации, но не во время обучения. С его помощью можно контролировать разнообразие получаемых изображений. При 𝜓 = 0 разнообразие равно нулю и все лица будут похожи на одно «усреднённое» лицо. При ±0.5 вы получите достаточно широкий диапазон образцов, а при ±1,2 увидите большое разнообразие лиц / стилей, но среди них будет много искажений. Рекомендуется установить значение около ±0.7 — так вы достигните баланса между качеством и разнообразием.

Случайные образцы

Видео

Самый простой способ — сделать скриншоты прогресса, сгенерированные по время обучения. Их размер увеличивается по мере повышения разрешения, поэтому следует выполнить сжатие с потерями или преобразование в JPG. Вот пример конвертации изображений с помощью FFmpeg:

Загрузка готовой модели

Можно загрузить готовую модель, обученную на 218794 образцах в течение

38 GPU-дней. Актуальная версия — от 8 марта 2019 года.

Перенос обучения

Одна из наиболее полезных вещей, которые можно сделать с обученной моделью StyleGAN — использовать её в качестве «стартовой площадки» для более быстрого обучения новой сети на меньшем объёме данных. Например, нашу модель можно переобучить на подмножество аниме-персонажей: рыжеволосых, мужчин, или на одного конкретного героя. Для этого понадобится около 500-5000 новых изображений, но иногда достаточно и 50.

Пример переноса обучения StyleGAN на персонажа Holo из “Spice&Wolf”:

И ещё один пример: Луиза из “Zero no Tsukaima”:

Она получилась не такой качественной из-за гораздо меньшего размера выборки.

Теперь, когда кому-то понадобится уникальная аниме-аватарка или эксклюзивная подборка портретов любимых героев, не нужно будет прочёсывать весь Интернет. А если вы поклонник манги, то генерация несуществующих вайфу — прекрасная возможность начать рисовать свои комиксы с неповторимыми персонажами. Хотя нейронные сети пока что сильно отстают от человека в плане творческих способностей, но уже сейчас они могут служить хорошим источником вдохновения.